Fredagsspecial: Är Google nya Nviddy?

- Fredrik

- 27 nov. 2025

- 19 min läsning

Eftersom att den Amerikanska börsen är stängd idag och jag förväntar mig en tråkig handelsdag så ställde jag frågan i Discord igår om ni vill ha Fredagsspecialen 1 dag tidigare. 73% röstade för att jag ska släppa den nu istället för på Fredag så here goes! Jag vill flagga för att det inte blir något morgonbrev/Fredagsspecial imorgon då ni får denna nu.

Teknikutvecklingen inom AI går i en rasande takt och ledarna för hela utvecklingen är halvledarbolagen. Marknaden har ett stort fokus på Nvidia, AMD och Broadcom, med all rätt! Men i skuggorna har vi en av techjättarna som har smugit sig fram och har nu blivit en direkt konkurrent med ovan nämnda bolag. Nämligen Google! Dagens Fredagsspecial kommer att handla om hur denna techjätte nu utmanar Nvidia. Är Google en Nvidia-mördare? Det är frågan vi ställer oss idag! Som alltid när vi pratar om halvledarsektorn så blir det många termer att hålla reda på. Jag kommer som vanligt att försöka beskriva allting så enkelt som möjligt så att även en person som inte följer sektorn kan hänga med i snacket. Nu kör vi igång! Googles Tensor Processing Unit aka TPU är en applikationsspecifik integrerad krets (ASIC) som är sektorns mest mogna och framgångsrika försök att koppla bort sig från Nvidias dominans, eller åtminstone minska ner på användandet av Nvidias väldigt dyra chip. För oss investerare har berättelsen om AI-hårdvara länge varit synonym med grafikprocessorn, GPU:er. Nvidias resa till att bli världens största bolag bygger på deras mjukvarustack CUDA och den enorma beräkningskraften i deras Hopper och Blackwell-arkitekturer.

Men i det tysta har Google gnetat på med sin helt egna design. Genom att designa sina egna chip har Google inte bara uppnått en tydlig kostnadsfördel för sina interna arbetsbelastningar såsom Sök, YouTube och Gemini utan man har också skapat en vallgrav som hotar den långsiktiga prissättningsförmågan hos leverantörer av GPU:er.

För att fullt ut förstå det strategiska hot som Google utgör så måste man först titta på den fundamentala skillnaden mellan en CPU, en GPU och en tensorprocessor aka TPU. Även om jag tror att många av redan har koll på CPU och GPU sedan tidigare så kommer här nedanför en kort beskrivning:

Centralprocessorn (CPU)

CPU:n är datorns hjärna och är byggd för att vara så flexibel som möjligt. Den är expert på att hantera varierarande uppgifter så som att driva operativsystemet och hantera det du gör på skärmen. Den arbetar genom att göra en sak i taget, steg för steg. Problemet är att detta arbetssätt är långsamt när man ska göra samma typ av uträkning miljarder gånger, vilket krävs för modern AI. För varje liten uträkning måste CPU:n stanna upp, hämta data och kolla vad nästa steg är, det är lite som en sommarjobbare på jobbet. Det går faktiskt åt mer energi till att bara hämta informationen och förbereda arbetet än att göra själva uträkningen. Det kan liknas vid en hantverkare som måste läsa om ritningen inför varje spik han slår i, istället för att bara hamra på.

Grafikprocessorn (GPU)

GPU:n utvecklades från början för att hantera grafik och datorspel där miljontals pixlar måste uppdateras exakt samtidigt. Därför består den av tusentals små hjärnor som arbetar parallellt, till skillnad från CPU:n som bara har några få. Nvidia skapade teknik som gjorde det möjligt att använda denna enorma parallella beräkningskraft även för andra typer av matematiska beräkningar vilket visade sig vara perfekt för AI. Men trots att GPU:n är överlägsen CPU:n på AI så är den inte 100% "specialiserad". Den är fortfarande en generalist som måste ha stöd för en mängd olika format och gammal grafikteknik som inte behövs för AI. Det gör att den drar med sig en del ineffektivitet. För att fungera optimalt krävs också en enorm kapacitet att skyffla data fram och tillbaka för annars svälter de tusentals små kärnorna på information och processen stannar upp.

Tensorprocessorn (TPU)

Till skillnad från CPU:n och GPU:n som är designade för att kunna göra flera olika saker så är Googles TPU en renodlad specialist. Den är designad enbart för att göra de tunga beräkningar som krävs för att träna AI. Den stora innovationen är hur den minimerar trafikstockningar i arbetsflödet. Vanliga processorer slösar mycket energi på att flytta data fram och tillbaka mellan minnet och själva räkneverket. TPU:n är byggd så att data kan flöda genom chippet i en enda rytmisk rörelse ungefär som ett hjärta som pumpar blod, utan att behöva mellanlanda i minnet hela tiden. Detta gör att den får mycket mer gjort per watt energi. Google har också skalat bort allt som inte behövs för AI. All hårdvara som GPU:n har kvar för att kunna rita grafik eller spela spel är borta. Kvar finns bara ren beräkningskraft. Det gör att chippet blir billigare och effektivare eftersom Google inte behöver betala för transistorer och funktioner som de ändå aldrig använder. Så vi kan förenklat säga att Google TPU är bättre, men på att göra väldigt få saker. Medan AMD och Nvidias chip har ett mycket bredare användningsområde. Så för att summera: CPU:n är datorns hjärna som klarar precis allt. Men eftersom den arbetar steg för steg och måste hantera mycket administration för varje liten uppgift så blir den ineffektiv för tunga AI-beräkningar. GPU:n löser detta genom råstyrka. Med tusentals kärnor som arbetar parallellt kan den hantera enorma mängder data samtidigt men den bär fortfarande på ett historiskt "bagage" av grafikteknik som tar onödig plats och energi.

Det är här TPU:n tar nästa steg. Den är designad uteslutande för AI och har skalat bort allt annat. Genom en unik arkitektur där data flödar rytmiskt genom chippet istället för att ständigt hämtas och lämnas i minnet så undviker den trafikstockningar och maximerar effektiviteten.

Nu ska vi titta lite snabbt på hur Googles resa mot att bli en viktig spelare i halvledarsektorn en gång började. Projektet startade i hemlighet runt år 2014-2015 och drevs av en intern insikt: om varje användare av Android-telefoner använde röstigenkänning i bara tre minuter om dagen så skulle Google behöva fördubbla sin datacenterkapacitet om de förlitade sig på dåvarande CPU:er. Detta var givetvis ohållbart i längden och lösningen blev att bygga eget.

TPU v1 (2015): Fokus låg initialt uteslutande på inferens. Detta chip distribuerades i Googles datacenter för att accelerera sök och översättning. Det var en ren inferensaccelerator. Enkel men väldigt effektiv för sin tid.

TPU v2 (2017) & v3 (2018): Nu tog Google steget från att bara använda färdiga AI-modeller till att faktiskt träna upp dem. Att lära en AI kräver mycket mer komplicerad matematik än att bara köra den (tänk skillnaden mellan att läsa en bok och att skriva en) så dessa chip utrustades med förmågan att hantera de avancerade decimaltal som krävs för inlärningen.

TPU v3 blev dessutom känd för att den var så kraftfull att vanlig luftkylning inte räckte. Istället leddes vätska direkt in i chippen för kylning vilket gjorde att Google kunde packa dem extremt tätt och få in enorm prestanda på liten yta.

TPU v4 (2021): TPU v4 (2021): En enorm milstolpe. Här började Google använda optik istället för bara vanliga sladdar för att koppla ihop servrarna. Det gjorde att de kunde koppla samman över 4 000 chip i ett supersnabbt nätverk som agerade som en enda gigantisk superdator.

TPU v5; Här delade Google upp tekniken i två olika spår för olika behov:

v5e (Effektivitet): Det ekonomiska valet. Byggt för att ge "mest AI för pengarna" när man kör vanliga, vardagliga uppgifter.

v5p (Prestanda): Det tunga artilleriet. Ett "prestandamonster" byggt med ett enda mål: att vara snabbt och kraftfullt nog att träna Googles allra största och smartaste AI-modeller, som Gemini.

Den sjätte generationen: Trillium (Ironwood)

Kärt barn har många namn, Trillium, v6e eller Ironwood är Googles direkta konkurrenten till Nvidias Blackwell-serie. Medan Nvidia tävlar om att bygga den enskilt snabbaste "motorn" (topp-FLOPS aka Floating Point Operations Per Second) fokuserar Google på att bygga den bästa "trafikflödet" för hela systemet.

Googles nya chip, Trillium, är ett monster i sig självt med en beräkningskraft på 4,6 petaFLOPS per chip. Många kliar sig säkert nu i huvudet och undrar vadfan en petaflop är, "kan det vara en uppföljare till Fopp-tofflorna?" Inte riktigt!

FLOPS är bara ett krångligt ord för "antal mattetal per sekund". Peta betyder en miljon miljarder. För att ge ett litet smakprov på den hastigheten: Om du gav en miniräknare till varenda människa på jorden alltså alla 8 miljarder, ish, inklusive alla gamlingar och kids så skulle vi alla behöva lösa över 500 000 mattetal i sekunden, (vardera) för att tillsammans hinna med vad ett enda sådant här chip gör. Skulle en person få i uppgift att lösa denna utmaning skulle det ta personen 31,7 miljoner år! Det är lång tid och det är tur att Googles senaste TPU:er inte är lika långsamma som oss ;)

Men den verkliga styrkan i chippet ligger i samarbetet. Tack vare designen kan tiotusentals sådana här monsterchip kopplas ihop och arbeta med nästan linjär skalning. Det betyder att om du dubblar antalet chip får du faktiskt ut dubbelt så mycket kraft utan det svinn som brukar uppstå i andra superdatorer.

En annan fördel är att stora språkmodeller kräver att data flyttas blixtsnabbt. Trillium använder därför 32GB av det senaste HBM3e-minnet. Det är samma kapacitet och hastighet som sitter i Nvidias allra dyraste grafikkort (H200/B200-klassen). Denna massiva bandbredd fungerar som en bredare motorväg vilket gör att processorn aldrig behöver sitta och vänta på information har fastnat eftersom att idioten framför dig har fått kärringstopp.

Idag begränsas datacenter inte av golvyta utan av hur mycket ström som finns tillgängligt. Här är Trillium en "game changer" med över 67% bättre energieffektivitet än sin föregångare. Att få ut så mycket mer "AI-kraft" per watt är en kritisk fördel när elektricitet är där skon klämmer. Google har redan installerat över 100 000-tals Trillium-chip för att driva sin nästa generation AI-modell, Gemini 3.0. Den släpptes förra veckan ock skapade en enorm "buzz" i marknaden. Jag själv är väldigt imponerad! Det som dock sticker ut något enormt är att i det finstilta står det klart att Gemini 3.0 inte tränades på Nvidias chip utan på sina egna TPU:er! I och med den egna utvecklingen av sina TPU:er är Google helt plötsligt inte lika beroende av andra bolag och till skillnad från exempelvis Altmans OpenAI så tränar man sina egna modeller på sina egna chip. Det är en stor skillnad!

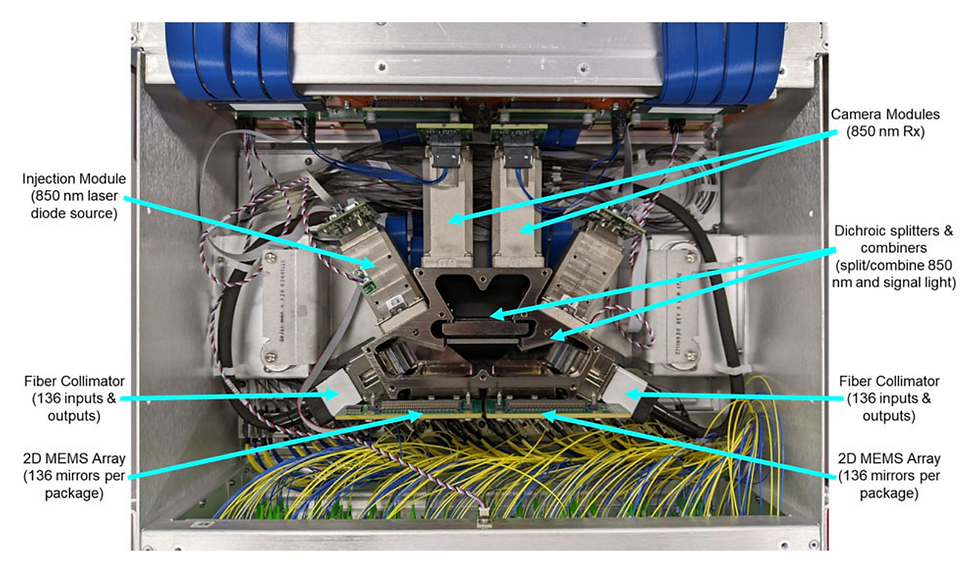

Google har löst ett av datacentrens största problem: hur man flyttar data snabbt utan att slösa massor energi. Lösningen kallas Optical Circuit Switching (OCS) och bygger på att skicka data med ljusstrålar som studsar mot mikroskopiska speglar.

Hur det fungerar: I vanliga nätverk måste datasignalen ofta stanna och göras om från ljus till elektricitet, läsas av, och sen göras om till ljus igen för att skickas vidare.

Det gamla sättet: Tänk dig ett tåg som måste stanna vid varje station. Alla passagerare måste kliva av, gå genom stationen och kliva på ett nytt tåg för att komma vidare. Det tar tid och kräver mycket energi.

Googles sätt (OCS): Här rör man aldrig passagerarna, alltså datan. Istället flyttar man själva rälsen. Genom att vinkla små speglar styrs ljuset eller i vårt exempel tåget, direkt till rätt destination utan att någonsin sakta ner eller omvandlas. Det sparar mycket tid och energi.

Denna teknik gör att Google kan "bygga om" sitt nätverk på en sekund. Behöver superdatorn plötsligt kopplas på ett helt nytt sätt för att lösa ett specifikt problem? Då vinklas bara speglarna om. I vanliga fall hade tekniker behövt dra om tusentals kablar för hand men nu sker det automatiskt. Eftersom Google slipper all utrustning som normalt krävs för att omvandla ljus till elektricitet och tillbaka så sparar de enorma mängder ström.

I vanliga system går upp till 30% av all ström åt bara till nätverket (switcharna).

Med OCS är den siffran under 5%.

När man har hallar fyllda med tiotusentals chip motsvarar den besparingen elförbrukningen för en hel liten stad. Dessutom blir det billigare att bygga eftersom man slipper köpa dyra omvandlare.

https://www.datacenterdynamics.com/en/analysis/mission-apollo-behind-googles-optical-circuit-switching-revolution-mag/

Nvidias lösning, baserad på förvärvet av Mellanox, använder InfiniBand. Detta är en beprövad, högpresterande standard. Men den är oflexibel. Att bygga om nätverket kräver att man fysiskt drar om kablar. Nvidias svar är NVLink Switch som är oerhört snabb men begränsad till färre GPU:er (oftast inom ett rack eller en rad). Google kan koppla ihop tusentals TPU:er över hela datacentret med OCS. Detta optiska försprång utgör en "vallgrav". Medan Nvidia pressar på för optiska sammankopplingar i framtida generationer (via NVLink över optik), har Google kört OCS i skarp produktion i stor skala sedan TPU v4. Här har man alltså ett tydligt försprång mot självaste Nviddy.

Nu ska vi titta närmare på hur Googles nya chip ritar om kartan för hela halvledarbranschen. Det här handlar inte bara om Google utan om hur deras vägval påverkar partners, konkurrenter och tillverkare.

1. Partnerskapet: Broadcom

Många tror felaktigt att Broadcom är en direkt konkurrent till Nvidia inom AI, men det är en sanning med modifikation då Broadcom inte ens tillverkar några GPU:er. Sanningen är snarare att de är ryggraden i "Anti-Nvidia-alliansen" där relationen med Google är lite av kronan på verket.

Du kan se på arbetsfördelningen så här:

Google är arkitekten: De designar logiken, alltså själva "hjärnan" i TPU:n. De bestämmer hur chipet ska tänka och hur mjukvaran ska prata med hårdvaran.

Broadcom är ingenjören: Google är ett mjukvarubolag i grunden och saknar viss expertis inom fysisk hårdvarudesign. Här kliver Broadcom in. De står för de kritiska "motorvägarna" (SerDes-teknik) som låter data flyga in och ut ur chippet i extrema hastigheter. De ser till att chippet faktiskt fungerar fysiskt och går att paketera.

Detta är en enorm affär. Broadcoms intäkter från Googles TPU-program väntas överstiga 10 miljarder dollar under kommande 12 månader, även om Broadcom själva inte har sagt rakt ut att det är just Google det handlar om så pekar alla ledtrådar just mot Google. I alla fall så gör detta Google till en av de viktigaste enskilda kunderna i hela världen för Broadcom.

https://www.cnbc.com/2025/10/13/broadcom-mystery-customer-openai.html I veckan när det blev mycket snack om framgången med Google TPU:er så var just Broadcom en av de starkaste aktierna. Detta tack vare deras nära samarbete med just Google.

2. Tillverkaren: TSMC

Varken Google eller Broadcom äger fabrikerna som faktiskt tillverkar chippen. Det uppdraget går till världens viktigaste företag och min personliga favorit: TSMC

Google Trillium tillverkas på TSMC:s 3nm-process vilket är den absolut mest avancerade tekniken som finns tillgänglig för massproduktion idag. Men nu har precis TSMC rullar igång sin 2nm-teknik och antagligen kommer vi se Google gå över till den framöver.

Det handlar inte bara om själva chippet, utan om hur det paketeras. TSMC använder sin avancerade paketeringsteknik CoWoS (Chip on Wafer on Substrate) för att "limma" ihop Googles logik-chip med de supersnabba HBM-minnena.

Det är samma teknik och produktionslinor som Nvidia slåss om för sina Blackwell-chip. Att Google säkrat kapacitet här visar att de har en "VIP-biljett" hos TSMC är helt avgörande för att kunna skala upp produktionen. Som jag har sagt många gånger förr, det fina med TSMC är att det inte spelar någon roll om vilket bolag som vinner AI-racet i slutändan. TSMC kommer ändå och stå där och leverera chip till alla bolag som vill in i AI-håsen.

Här ser vi ju också hur pass stupid marknaden kan vara. Man tänker alltid att markanden är smart, men det stämmer fan inte. I det korta perspektivet ser man ofta väldigt många korkade rörelser. I veckan föll TSMC tillexempel med 4,2% på grund av rädslan att Googles TPU:er utmanar Nvidias GPU:er. Det marknaden verkar ha missat var dock att TSMC även tillverkar Googles chip.

3. Konkurrenten: Nvidia

Googles framgång med TPU:er har länge setts som ett visst hot mot Nvidias dominans, men fram till nu har argumentet varit att det mest handlar om interna besparingar för Google och att bolaget till viss del kan sätta press på Nvidias priser. Enligt Google själva har det inte heller låtit som om att det finns någon långsiktig plan på att sälja sina TPU:er till andra techbolag, i alla fall inte i någon större skala. Men veckans nyhetsflöde ändrar allt.

Det som tidigare var en situation där Google byggde chip nästan uteslutande för eget bruk har nu utvecklats till något helt annat. Enligt färska uppgifter för Meta Platforms diskussioner om att köpa Googles TPU-chip för miljardbelopp. Meta planerar att hyra kapacitet via Googles moln nästa år för att sedan, potentiellt, installera chipen i sina egna datacenter 2027. Detta innebär att Googles TPU inte längre bara är en intern effektiviseringsåtgärd utan det är nu en kommersiell produkt som säljs direkt till Nvidias största och viktigaste kunder.

Det är viktigt att förstå att Google fortfarande är en av Nvidias största kunder och att man antagligen kommer att vara det under en lång tid framöver:

När Google (och kunder) använder Nvidias GPU:er:

Standardiserad Cloud-uthyrning: Google kommer fortsätta köpa tiotusentals H100/Blackwell-chip. Varför? För att "gemene man" och företag som Spotify (som är en av många kunder i Google Cloud-tjänster) ofta vill köra sin kod i Nvidias standardmiljö CUDA. Här agerar Google fortfarande återförsäljare och tjänar pengar på Nvidias ekosystem.

Experimentell forskning: Nvidias chip är fortfarande mer flexibla för bolag och forskare som testar helt nya, icke-optimerade arkitekturer.

När Google (och nu även andra) använder TPU:er:

Interna produkter (Search/YouTube/Gemini): Här är TPU:er kung. Det är mer kostnadseffektivt och Gemini 3.0 tränades uteslutande på dessa.

Strategiska partnerskap: Det här är den nya "Nvidia-dödaren". Att Meta som är ett bolag med i princip obegränsade resurser, lite kryddat, men ni förstår poängen, överväger att köpa TPU:er är en enorm validering av tekniken. Det bevisar att TPU:er inte bara fungerar för Google utan att dem är ett reellt alternativ för andra techjättar som vill minska sitt beroende av Nvidia.

Enligt en analys från Morgan Stanley har Google under det gångna året lagt betydligt större resurser på att köpa hårdvara från Nvidia än på sina egna TPU:er. Banken uppskattar att Google spenderat cirka 20 miljarder dollar på Nvidia-chip vilket är ungefär dubbelt så mycket som investeringarna i den egna TPU-infrastrukturen.

Morgan Stanley noterar att Nvidia därmed har stärkt sin andel hos Google i år men bedömer också att pendeln kommer att svänga tillbaka något till förmån för TPU:er under nästa år. Analysen understryker också att AI-racet inte är en marknad där vinnaren tar allt och att den är tillräckligt stor för flera vinnare. Detta är en viktig poäng. Trots framgångarna med sina egna chip har man fortfarande spenderat dubbel så mycket pengar på att köpa chip från Nvidia.

https://x.com/jukan05/status/1993569781379953058 Vad innebär detta för Nvidia?

Tidigare var risken "bara" att Google slutade köpa Nvidia-chip för eget bruk. Nu är risken att Google börjar stjäla delar av Nvidias andra kunder och detta är helt nytt, främst inom egen utveckling. Som sagt, all tidigare kommunikation från Google själva och andra bolag i sektorn har pekat på att Google more or less enbart ska använda sina TPU:er för eget bruk och i vissa fall (i mindre skala) erbjuda det till andra techbolag.

Men om Google och Amazon bygger sina egna chip (Google TPU, AWS Trainium) och börjar sälja/hyra ut dem till varandra så urholkas Nvidias totala adresserbara marknad. Affären med Meta sätter också en enorm prispress på Nvidia. Om Google kan erbjuda Meta en lösning som är billigare och lika effektiv sätter det ett tak för vad Nvidia kan ta betalt för sina Blackwell-chip. Google har gått från att vara en kund med förhandlingsstyrka till att bli en leverantör som aktivt konkurrerar om plånboken (i vissa fall) hos "The Magnificent Seven". Det är viktigt att komma ihåg att Nvidia har fortfarande vallgraven kvar i sin mjukvara CUDA för den breda massan och att deras chip har ett mycket bredare användningsområde. Men muren mot de allra största spelarnas chip för eget bruk har just fått en rejäl spricka under veckan! Om man vill vara lite "konspiratorisk", vilket alltid är roligt, så vore det inte konstigt om fler av de stora techjättarna köper chip av Google i ett "uppror" mot Nvidas enormt höga priser och brutala marginaler. Om detta sker kan vi nog se ett väldigt pressat Nvidia. Jag brukar beskriva halvledarsektorn lite som ett Paradise Hotel och nu blev det hela än mer dramatiskt!

4. Mellangärdet: AMD

AMD försöker positionera sig med sina MI300-chip som det "öppna" och kostnadseffektiva alternativet till Nvidia men deras karta över kunder är uppdelad i två läger.

Hos Google och Amazon är dörren för intern AI i princip stängd för AMD. Google behöver inte ett "billigare Nvidia" utan de har redan sina TPU:er som är optimerade in i minsta detalj för deras egna behov. Det är osannolikt att Google skulle byta ut sina egna chip mot AMD för kärntjänster som Sök, YouTube eller Gemini. Samma "mur" möter AMD hos Amazon som satsar stenhårt på sina egna Trainium-chip. Här får AMD nöja sig med att vara en leverantör av vanliga serverprocessorer, CPU:er, och eventuellt enstaka molninstanser för externa kunder.

Hos Microsoft och Meta ser det ljusare ut för AMD. Till skillnad från Google har jättar som Microsoft och Meta valt att släppa in AMD i värmen. De köper in AMD:s AI-chip i stora volymer inte för att de saknar egna projekt utan för att de behöver diversifiera sig bort från ett totalt beroende av Nvidia. För Microsoft och Meta fungerar alltså AMD som ett vapen för att pressa Nvidias priser. För resten av marknaden, det vill säga de företag som inte kan bygga egna chip, är AMD det enda realistiska alternativet om man vill ha hög prestanda utan att betala Nvidias premiumpriser eller stå i deras långa leveransköer.

5. Valideringen: Apple, Anthropic och nu även Meta Platforms

Det starkaste beviset för att Googles chip fungerar är inte vad Google säger i sina pressmeddelanden utan vad deras konkurrenter och partners faktiskt gör med sina pengar.

Att Apple, världens mest kvalitetsmedvetna och hemlighetsfulla bolag valde att träna grunden för "Apple Intelligence" på Googles TPU:er istället för Nvidias GPU:er skickade en chock genom sektorn. Det handlar inte om att Apple saknar pengar för att köpa Nvidia-chip. Det handlar om att de såg en teknisk stabilitet och tillgänglighet hos Google som kunde matcha deras extremt höga krav. Att Apple vågar bygga sin framtid på Googles infrastruktur validerar TPU:n som en mogen plattform redo för konsumentprodukter i världsklass.

Anthropic: En av världens ledande AI-utmanare och OpenAI-konkurrent har skrivit avtal om att använda Google Cloud och dess TPU:er för sina beräkningar. Detta är inte bara en teknisk validering utan en strategisk manöver. Genom att investera i Anthropic och samtidigt binda dem till TPU-infrastrukturen skapar Google en "flywheel-effekt": Anthropic får beräkningskraft och Google får en enorm testpilot som pressar hårdvaran till gränsen vilket i sin tur gör den bättre för alla andra kunder. Meta: Som nämnt ovan blev Meta kund under veckan och jag behöver inte rabbla på mer om det.

När väntetiderna på Nvidias chip kan vara upp till ett år kan Google erbjuda omedelbar tillgång till sina TPU-kluster och nu då även börja sälja chippen direkt till kunderna. Detta lockar särskilt snabbväxande "AI Unicorns" som Midjourney och Character.ai, som behöver enorm kraft här och nu och inte 1 år bort. Genom att kontrollera hela kedjan från chip till nätverk och mjukvara kan de erbjuda en optimering som är svår att matcha för de som bara plockar ihop delar från olika leverantörer. Ju fler företag som tröttnar på Nvidias höga priser desto fler kommer sannolikt att söka sig till Googles hyrlösning.

https://www.cnbc.com/2024/07/29/apple-says-its-ai-models-were-trained-on-googles-custom-chips-.html Innan vi summerar ihop detta så vill jag slänga fram en annan teori om hur Google landade Meta som kund. Både GPU:er och TPU:er begränsas helt och hållet av TSMC:s produktionskapacitet av wafers och tillgången på el till datacenter. För de mest avancerade språkmodellerna ger Nvidias GPU:er fortfarande bäst prestanda per kiselplatta. Även om TSMC kommer tillverka chip åt flera aktörer såsom Google, Amazon, Meta för att sprida sina risker kommer mindre ASIC-utmanare ha svårt att få tillräcklig kapacitet och optimering. Vad är problemet med detta? Mjo att TSMC väljer själv sina kunder. Om jag och Pianoman idag skapar ett designbolag och ringer upp CC Wei och säger "Tjena, du vi vill ha lite produktionskapacitet på 3nm och 2nm, vi tänker att vi ska skapa 1000 chip". Vi hade antagligen inte fått något svar alls, men om vi hade fått ett svar så hade det varit "sry vi har all produktionskapacitet fullbokad med våra stora kunder.". Om vi nu går vidare till att göra en äkta servett-kalkyl baserat på vad vi vet om branschen, kan vi göra en gissning på vad Google och Metas avtal faktiskt innebär. Ta dessa siffror med en stor nypa salt.

Här är matematiken bakom höftningen:

Vad kostar ett "high-end" AI-chip? Nvidias H100 (som är standarden) kostar runt 25 000 – 30 000 dollar styck på öppna marknaden. Även om TPU:er inte säljs öppet, är det rimligt att anta att värdet i ett sådant här avtal ligger någonstans i närheten kanske med en viss "kompisrabatt" eller volymrabatt. Låt oss räkna lågt på 20 000 dollar per chip.

Vad betyder "miljarder"? Artikeln säger att Meta ska köpa chip för "miljarder dollar", alltså plural. Låt oss anta att det rör sig om en investering på mellan 2 och 5 miljarder dollar.

Uträkningen:

Lågt scenario (2 miljarder dollar): $2 000 000 000 / $25 000 per chip = 80 000 TPU:er.

Högt scenario (5 miljarder dollar): $5 000 000 000 / $20 000 per chip = 250 000 TPU:er.

Slutsats: En rimlig "höftning" är att det handlar om mellan 50 000 och 150 000 chip.

Det skulle vara en enorm order som gör Google till en av Metas absolut viktigaste leverantörer vid sidan av Nvidia. Så alright, Meta kanske köper mellan 50.000 - 150.000 chip av Google som i sin tur lägger denna beställning hos TSMC. Sen adderar vi också in Google egna behov av TPU:er för 2026 som bör ligga någonstans kring en halv miljon chip. Nu är Google, tillsammans med ordern från Meta helt plötsligt en signifikant kund hos TSMC. Man får en prio och kanske ännu viktigare är att när man väl blivit en stor och viktig kund hos TSMC så gör man det svårare för andra, mindre kunder, att köpa produktionskapacitet. Jag tror att detta är en stor del av dealen. Google själva ville säkra upp sin del av TSMC:s produktion så man gick helt enkelt över till Zuckerberg och sade "Shuu, vill du ratta våra TPU:er och säkra upp chip för nästa år? Ge oss några miljarder USD så löser vi kapacitet hos TSMC". För att summera kan denna deal ha varit ett sätt att låsa upp produktionskapacitet hos TSMC för nästa år och samtidigt göra det svårare för andra aktörer att få ta del av TSMC:s produktion. För vem tror ni CC Wei väljer? 500 kunder som mig och Piano, eller en kund som Google? 👀 Nu ska vi över till nästa del i denna utläggning och det är att Samsung bör befinna sig i ett guldläge. Får man ordning på sin 2nm produktion så finns det många och väldigt stora avtal att vinna. Alla techjättar skriker efter mer produktionskapacitet och för stunden är det egentligen enbart TSMC som kan leverera. Rycker Samsung upp sig finns det mycket pengar att tjäna.

Slutsats

TPU:n är en "dold tillgång" som marknaden verkar ha underskattat hos Google. Antagligen är TPU:erna värda hundratals miljarder i "undviken kostnad". Den säkrar Googles framtid inom AI mot leveranschocker och prishöjningar från Nvidia.

Men är Google en Nvidia-mördare? Nej, det tror jag inte. Nvidia sitter för säkert i sin båt. Men kommer de att pressa Nvidias marginaler? Ja, det tror jag absolut att vi kommer att se över tid. När jättar som Google och Amazon bygger egna och i vissa fall bättre alternativ för sin egna användning sätter de ett tak för vad Nvidia kan ta betalt och det kommer att pressa marginalerna. Nu när veckans nyheter också visar på att Google antagligen har långsiktiga planer för att sälja sina TPU:er till andra Big-Tech bolag så har spelplanen ändrats om. Vi går mot en värld där olika chip jobbar sida vid sida men där de stora teknikbolagen tar tillbaka kontrollen genom att bygga hårdvaran själva. Jag vill dock vara väldigt tydlig med att poängtera att marknaden för AI just nu är gigantisk. Den är för stunden omättlig. Det finns plats för fler spelare. Det finns goda anledningar till varför väntetiderna på Nvidias chip är en bra bit över 12 månader, och det är för att utbudet är mycket lägre än efterfrågan. Jag tror mer att man ska se Googles TPU:er som ett komplement i det hela och inte en Nvidia-mördare som många vill få det att låta som. Däremot anser jag att Nvidia över tid inte kommer kunna behålla sin vinstmarginal kring 55%. Tror man på det är man nog naiv! Konkurrensen kommer och den kommer snabbt även om Nvidia ser ut att förbli herren på täppan!

Ska jag också slänga in ett "bold bet" så tror jag fan att Google i och med håsen kring Gemini 3.0, deras TPU:er och Buffetts inträde i bolaget kan skicka upp bolaget till att bli världens mest värdefulla bolag. Det vill säga att dem kommer att gå om Nvidia. Jag tänker mig att Nvidias aktie kan pressas en del i närtid om det kommer fler nyheter kring TPU:erna. Vad säger ni om det? Detta stycke skrev jag i Måndags och nu när vi sitter här på Torsdagen ser detta inte alls lika "bold" ut, det går fort i hockey och på börsen 😅

Nästa vecka ska vi prata om en annan techjätte, nämligen Amazon, som ser ut att försöka sig på samma move som Google. Det var vad jag hade att säga om Google TPU:er. Det finns givetvis mängder med tekniska detaljer att gå in på. Vill man läsa mer om Googles TPU:er så rekar jag att läsa in på källorna länkade nedanför. Tack för att ni har läst! Källor: https://cloud.google.com/blog/products/ai-machine-learning/an-in-depth-look-at-googles-first-tensor-processing-unit-tpu https://medium.com/@aayushbhatnagar_10462/nvidia-blackwell-vs-google-tpu-trillium-the-battle-for-ai-compute-in-2025-23de5ea41a80 https://arxiv.org/pdf/2304.01433 https://www.macrumors.com/2024/07/30/google-chips-used-to-develop-apple-intelligence/ https://wccftech.com/anthropic-has-turned-up-the-heat-on-nvidia-with-the-latest-google-tpu-deal/ https://www.cloudoptimo.com/blog/tpu-vs-gpu-what-is-the-difference-in-2025/

Väldigt grundlig välskriven och helt enkelt fantastisk summering av Google. Ju mer jag läser och funderar på google desto mer tungt vill jag äga aktien. Google kommer vara mitt absolut största enskila innehav 2026